![]() Fertige Antworten oder gar eine Anleitung, wie wir mit Künstlicher Intelligenz umgehen sollten und müssen – das gibt es in der Dokumentation Coded Bias der Regisseurin Shalini Kantayya leider nicht. Dafür ist der Film der aktuell beste, der sich dem Thema widmet und dabei die Probleme rund um Diskriminierungen im Blick hat. Am Beispiel der Gesichtserkennung verknüpft Kantayya die Geschichte der KI-Forscherin und Aktivistin Joy Buolamwini mit weiteren Beispielen aus der Praxis und zahlreichen Interviews mit Expertinnen.

Fertige Antworten oder gar eine Anleitung, wie wir mit Künstlicher Intelligenz umgehen sollten und müssen – das gibt es in der Dokumentation Coded Bias der Regisseurin Shalini Kantayya leider nicht. Dafür ist der Film der aktuell beste, der sich dem Thema widmet und dabei die Probleme rund um Diskriminierungen im Blick hat. Am Beispiel der Gesichtserkennung verknüpft Kantayya die Geschichte der KI-Forscherin und Aktivistin Joy Buolamwini mit weiteren Beispielen aus der Praxis und zahlreichen Interviews mit Expertinnen.

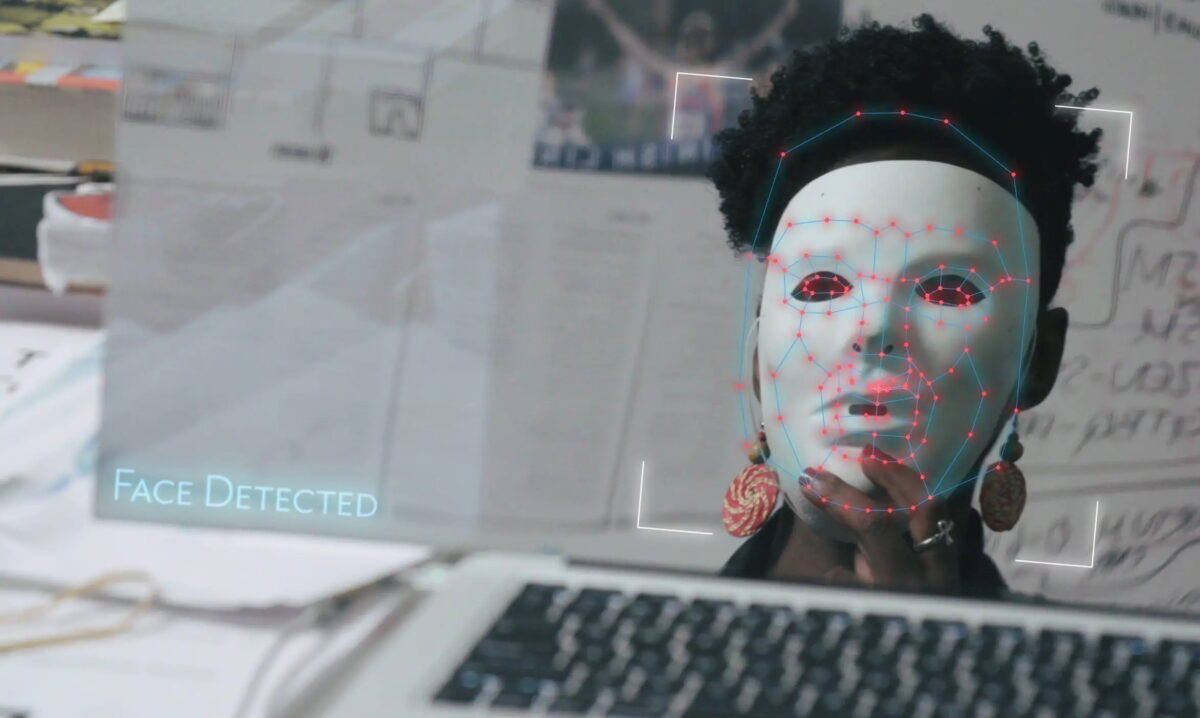

Buolamwini untersuchte für ihre Doktorarbeit, wie zuverlässig verschiedene Algorithmen Gesichter erkennen, nachdem sie mit einem interaktiven Roboterprojekt gescheitert war. Die von ihr verwendete Software erkannte einfach nicht ihr Gesicht – eine weiße Theatermaske dagegen schon. Auch Programme anderer Firmen waren vor allem dann erfolgreich, wenn sie weiße Männer erkennen sollten und versagten zunehmend, je weniger weiß und je weniger männlich eine Person erschien. Ähnliche Probleme sind seither in anderen Einsatzgebieten Künstlicher Intelligenzen deutlich geworden. Mit der Algorithmic Justice League setzt sich Buolamwini daher für mehr Gerechtigkeit bei der Anwendung von Algorithmen ein und wird schließlich sogar für eine Anhörung vor den US-amerikanischen Kongress eingeladen.

Neben dieser Reise zeigt die Doku sie auch beim Einsatz für die überwiegend Schwarzen Bewohner_innen eines Hauses, deren Verwaltung die physischen Schlüssel zugunsten eines Systems mit solch – fehleranfälliger – Gesichtserkennung austauschen möchte. Dass die Entwicklung neuer Technik oft von privilegierten Personen kommt, den Einsatz und daraus folgende Einschränkungen und Strafen aber weniger Privilegierte als Erste erleben, machen auch die weiteren Beispiele in Coded Bias deutlich.

Jobverlust durch KI-Entscheidung

Die Initiative Big Brother Watch von Silkie Carlo etwa protestiert in London gegen ein Pilotprojekt mit Gesichtserkennung. Während einer Aktion durchsuchen Polizisten einen Schwarzen Schuljungen und nehmen direkt auf offener Straße seine Fingerabdrücke – wie sich herausstellt, war es eine Verwechslung durch das System. In Houston verliert ein mehrfach ausgezeichneter Lehrer beinahe automatisch seinen Job, nachdem ihn ein Algorithmus als mangelhaft bewertet hat. Wie die Entscheidung zustande kam, konnte allerdings niemand erklären.

Dass automatisierte Systeme so über das Leben von Menschen entscheiden und dabei als Black Boxes agieren, also von außen quasi uneinsehbar sind, ist ein Problem, so der Tenor des Films. Dazu kommen außerdem zahlreiche Expertinnen zu Wort. Das Femininum ist bewußt gewählt, denn von Zeynep Tufekci über Safiya Noble bis hin zu Timnit Gebru sind es vor allem Frauen bzw. Women of Colour, die sich mit Diskriminierung in Algorithmen beschäftigen. Sie machen deutlich: Derzeit automatisieren wir mit neuer Technik vor allem alte Vorurteile.

Mehr Fragen als Antworten

Dass diese Kritik so zeitnah aufkommt, während Künstliche Intelligenz zwar bereits eingesetzt wird, aber noch nicht flächendeckend, macht den Film – wie die gesamte Debatte – äußerst spannend. Fertige Gegenstrategien gibt es allerdings nicht. Beliebte Forderungen, wie „mehr Frauen an der Entwicklung beteiligen“ werden nicht helfen, denn wie Buolamwini deutlich macht, war es für sie als Schwarze Frau gleich doppelt so schwer, mit ihrer Arbeit von den Softwarefirmen ernst genommen zu werden. Außerdem muss das Thema größer gedacht werden, so die Forscherinnen: Welche Herausforderungen stellt KI an Demokratien? In welcher Form kann und sollte ihr Einsatz reguliert werden und welche Level an Transparenz sind nötig?

Dazu passend gibt es auf der Webseite zum Film eine Take-Action-Seite mit einem Toolkit für Aktivist_innen, einer Anleitung für eigene Aufführungen und anschließende Diskussionen. Wer mag, kann schließlich die Universal Declaration of Data Rights as Human Rights mitzeichnen und mehr Kontrolle über die eigenen Daten sowie Grenzen für den Einsatz von KI-Systemen fordern.

Der einzige Knackpunkt an dem Film: Es klingt wieder einmal, als ob es in China „ein“ Social-Scoring-System gebe, mit dem die gesamte Bevölkerung ständig bewertet und überwacht würde. Tatsächlich gibt es dort sogar verschiedene Social-Scoring-Projekte, aber bis heute kein allgegenwärtiges, staatliches Überwachungssystem. Trotzdem lohnt das Anschauen, denn Kantayya bringt die feministischen und antirassistischen Kritiken an Gesichtserkennung und KI der letzten Jahre anschaulich zusammen. So ist der Film besonders für alle, die sich bisher wenig mit dem Thema beschäftigt haben, ein guter Einstieg.

Die Dokumentation Coded Bias ist seit Anfang April auf Netflix anzusehen – allerdings nur auf Englisch mit deutschen Untertiteln.